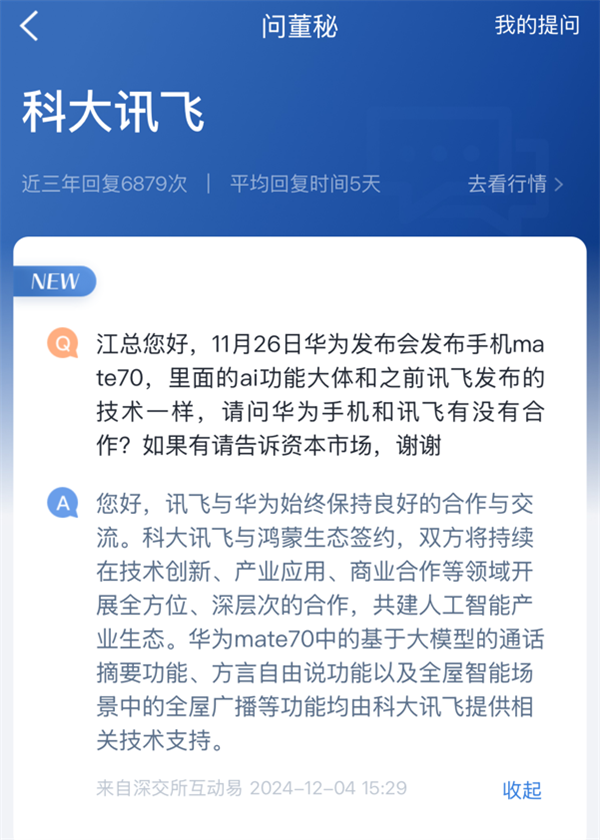

新智元报道 编辑:peter东 乔杨【新智元导读】大模型如今已具有越来越长的上下文,而与之相伴的是推理成本的上升。英伟达最新提出的Star Attention,能够在不损失精度的同时,显著减少推理计算量,从而助力边缘计算。当下的手机及AIPC中都会安装本地大模型,然而上下文长度增加,推理时的计算成本也会显著增长。最明显的一个后果就是,用户输入问题后需要等待很久才能看到结果。为此,已有多种优化方案提出,例如Flash Attention,而11月26日英伟达提出的Star Attention机制,可用于提升Transformer模型在处理长序列时的效率和准确性。值得一提的是,这篇文章受到了广泛的关注,登顶Hugging Face每日论文榜首。 论文地址:https://arxiv.org/abs/2411.17116 Star Attention如何降低推理成本在了解Star Attention如何改进大模型推理前,让我们先看

英伟达提出全新Star Attention,10倍加速LLM推理!登顶Hugging Face论文榜

2024-12-05 00:00:00来源: 新浪人工智能

赞

你的鼓励是对作者的最大支持

- 孕期1天吃4次外卖,血脂超标10倍!这3类食物,孕妈可千万别碰2024-12-05 00:00:00

- 坐月子时,这10件事提前跟家人说,避免不必要的麻烦2024-12-05 00:00:00

- 英伟达或提前发布Rubin架构GPU:或通过加快架构迭代巩固市场主导地位2024-12-05 00:00:00

- 英国开发者针对苹果的 10 亿美元级集体诉讼案获准继续,后者被指垄断 iPhone 应用销售2024-12-04 00:00:00

- xAI以10亿美元敲定英伟达AI芯片优先交付?马斯克点了个赞2024-12-04 00:00:00